皆さま、いかがお過ごしでしょうか。歌乃です。

自作ゲームに使用する素材を探していたのですが、なかなかこれと言うものがみつかりません。

資金もないのでフリー素材を求めるわけですが、そうするとどーしても「ここが足りない」という状況に陥ります。

基本的に素材は自作する派なのですが、クオリティを求めると自作以外の素材に目がいってしまいます。

そうしているうちに「もうこれ AI に生成させたほうが早いんじゃね?」という天からのお告げが(幻聴

ということで AI 画像生成環境をローカルに構築してみました。

筆者の環境は Windows 10 です。 いつものごとくほとんどが戯言です。

Table of Contents

AI 画像生成環境っていっぱいあるんだね

一概に AI 画像生成環境といっても最近ではかなりの数があるようです。

こんなときには長いものに巻かれろの精神で、今回「Stable Diffusion WebUI」を使ってみようと考えました。

Stable Diffusion WebUI を構築

ありがたいことに「Stable Diffusion WebUI」は Windows + Python + Git で構築できるようです。

Stable Diffusion WebUI はPython 3.10.6 でテストしているとの事で、他のバージョンだとうまく動かないかもしれないとの警告がでます。

事前に Python 3.10.6 をインストールしておいてください。

> git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git

> cd .\stable-diffusion-webui\

\stable-diffusion-webui> py -3.10 -m venv .\venv\

\stable-diffusion-webui> .\venv\Scripts\activate

(venv)> .\webui.bat以上の手順で構築できます。バッチファイルが用意されているので簡単ですね。

依存関係のモジュールも含めてインストールされるので、結構時間がかかります。お茶でも飲みながらのんびり待ちましょう。( ゚Д゚) _旦~~

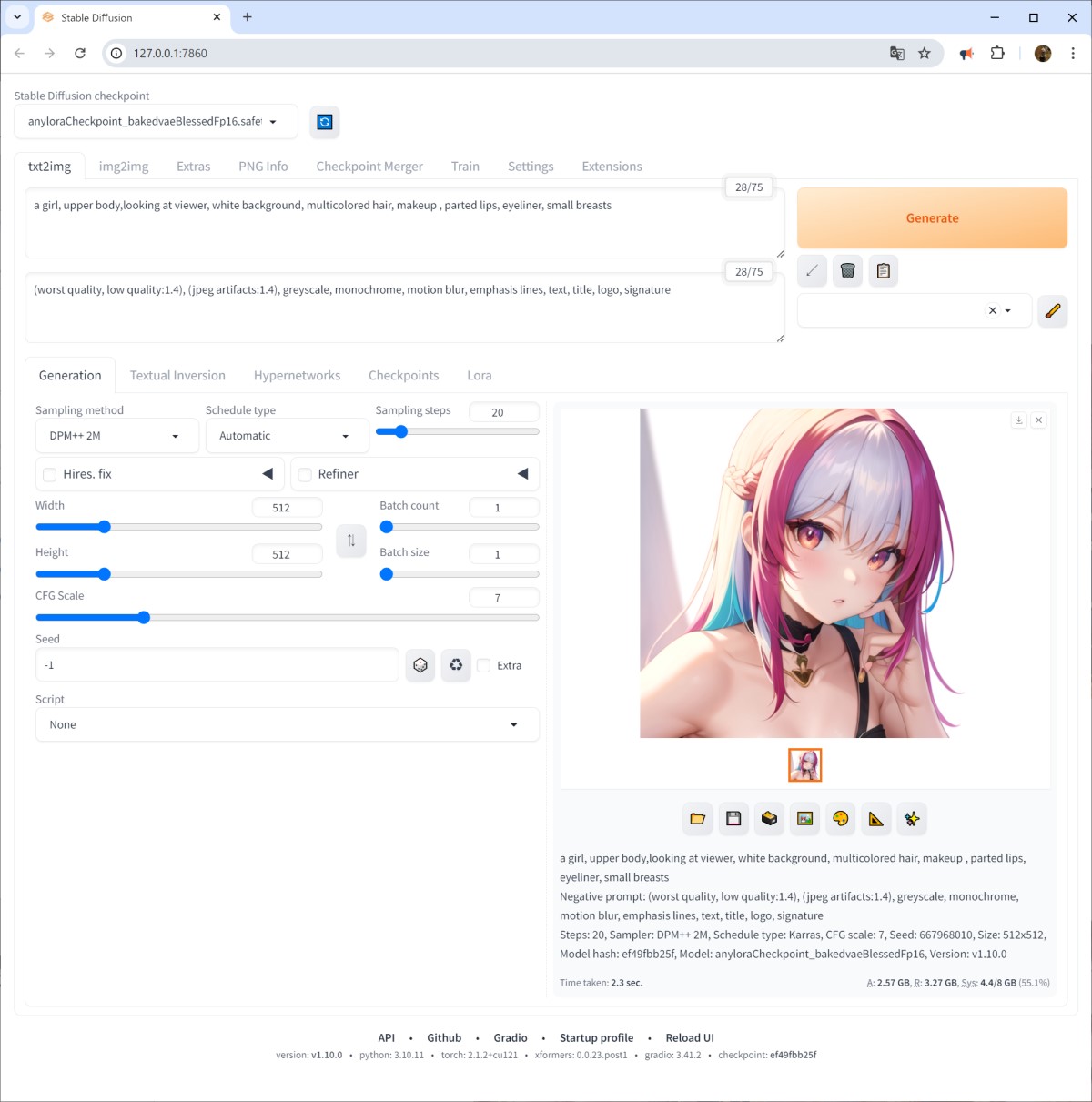

インストールが完了するとお使いのブラウザに「http://127.0.0.1:7860/」のアドレスで「Stable Diffusion WebUI」が表示されます。

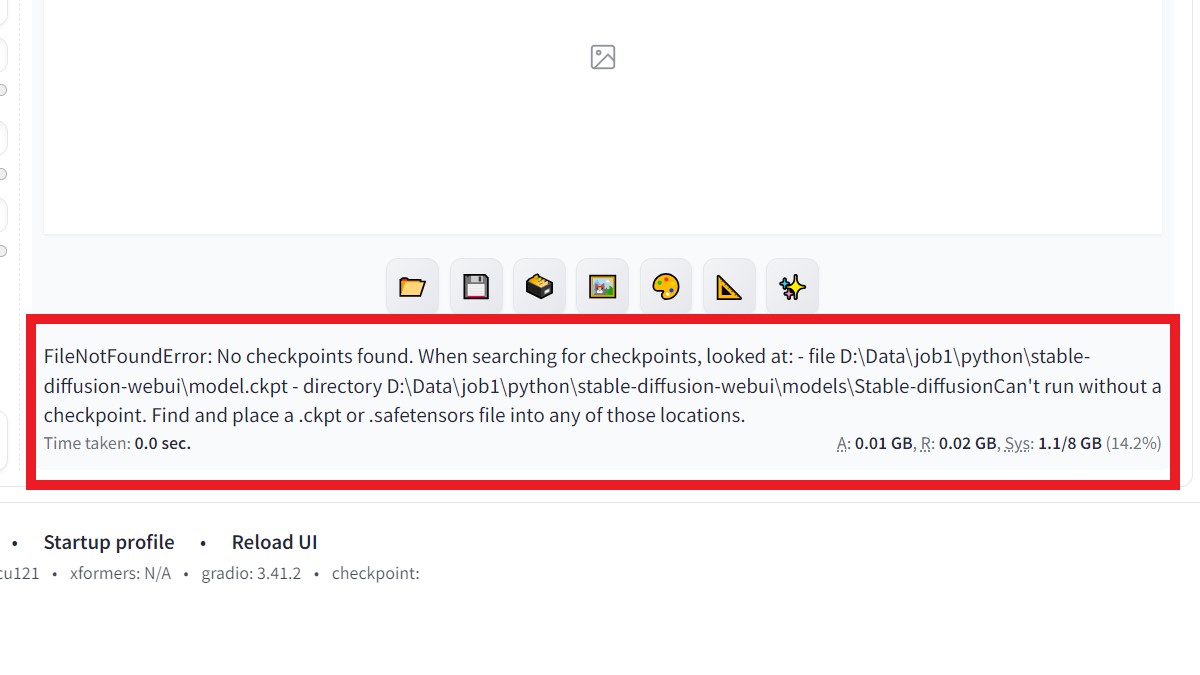

エラーが出た場合

が、しかし。いざ画像生成させようとすると、エラーが出て画像が生成されません。

調べてみると、どうやら、環境構築時に「画像生成用学習モデル(いわゆるAIの経験に当たる部分)」の取得に失敗しているようです。

つまり、生成用のモデルが見つからないから生成できないっ、と怒っているわけです。

AI モデルご用達サイト huggingface から stable diffusion の基本モデルのチェックポイント (.ckpt) をダウンロードしてきます。

https://huggingface.co/stabilityai/stable-diffusion-2-1-base

ブラウザのページを再読み込み。

もしくは画面下の「Reload UI」をクリック。

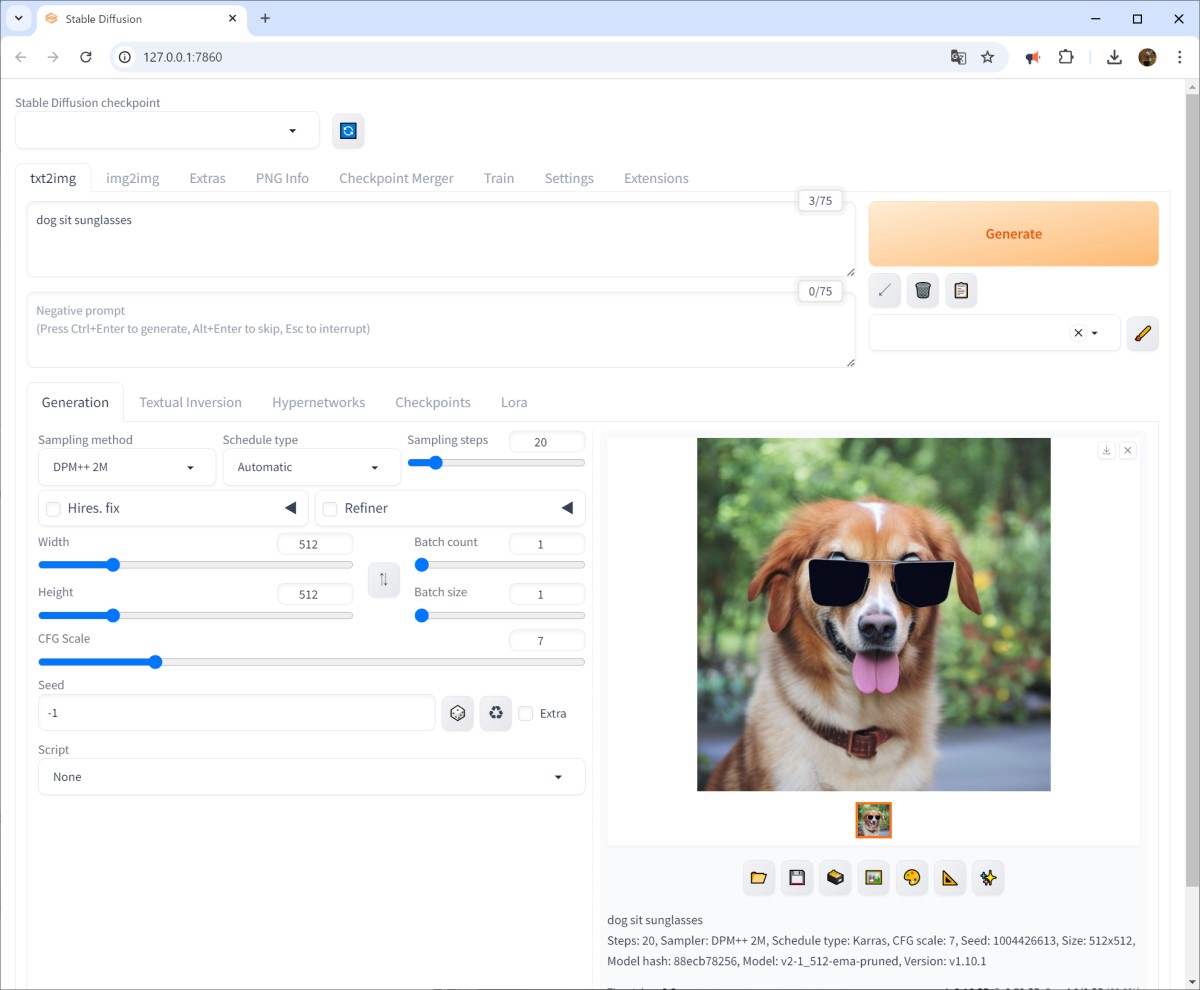

今度はちゃんと画像が生成されました。

ちなみに、ブラウザを閉じても Stable_Diffusion_WebUI は終了しません。

コンソールの方で Ctrl + C で終了させてください。

ここまで書いておいてなんですが、ここからが本題です。

StabilityMatrix

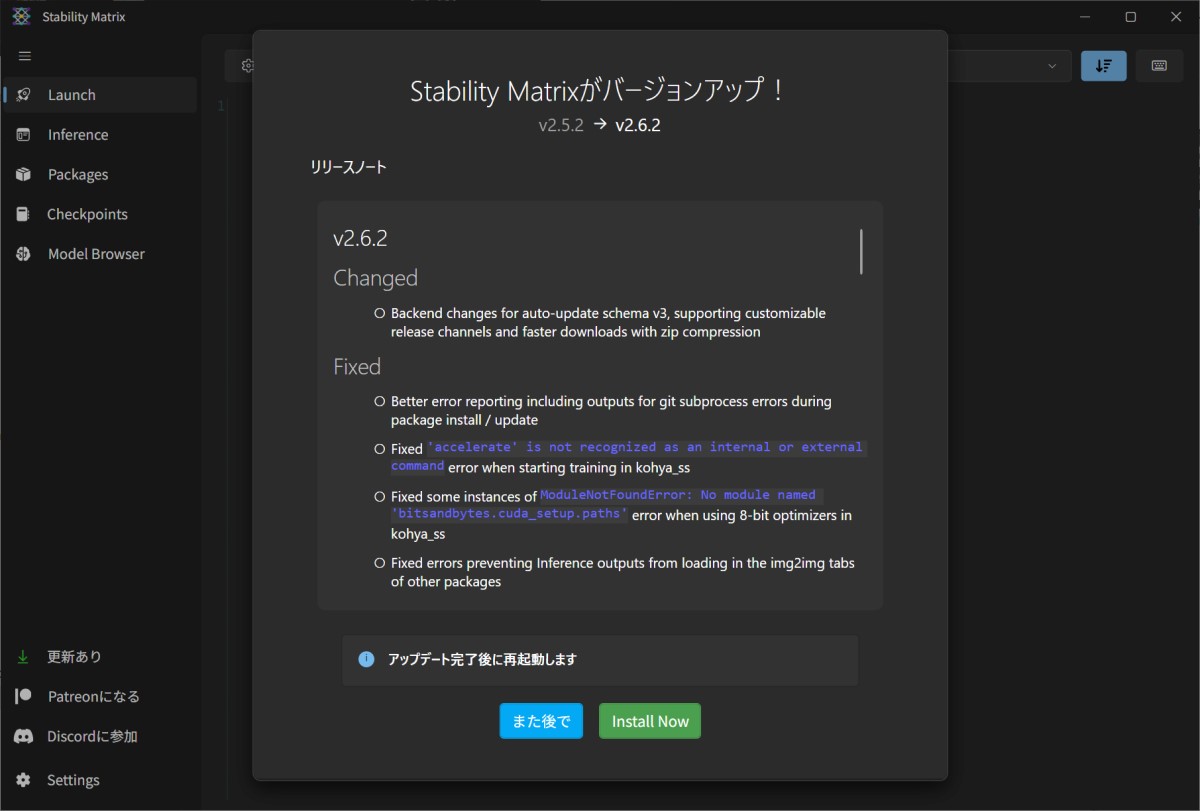

タイトルにある様に「StabilityMatrix」という前述でやった手順をすべてワンオペでやってくれるアプリがあるそうです。

手間暇かけて Stable_Diffusion_WebUI 構築したのに(´・ω・`)

まあ気を取り直して StabilityMatrix 入れてみましょう。

本体をダウンロード

github からリリース版をダウンロードします

https://github.com/LykosAI/StabilityMatrix/releases

windows 環境なので StabilityMatrix-win-x64.zip をダウンロードします。

この記事の時点でバージョンは v2.11.8 でした。

zipを解凍すると「StabilityMatrix.exe」という実行ファイルがあります。

おもむろに実行(信頼性などの警告が出た場合は個別に対処してください、うちは出ませんでした)。

背景が黒というだけでなんだか怪しく見えてしまう不思議。使用許諾にチェックを入れて続行。

データフォルダのPathを聞かれますが、一旦キャンセルして、

先に左側に出ている、更新(アップデート)を行います。

更新は複数回必要な場合があります。更新メッセージが出なくなるまで(最新版になるまで)アップデートしてください

パッケージのインストール

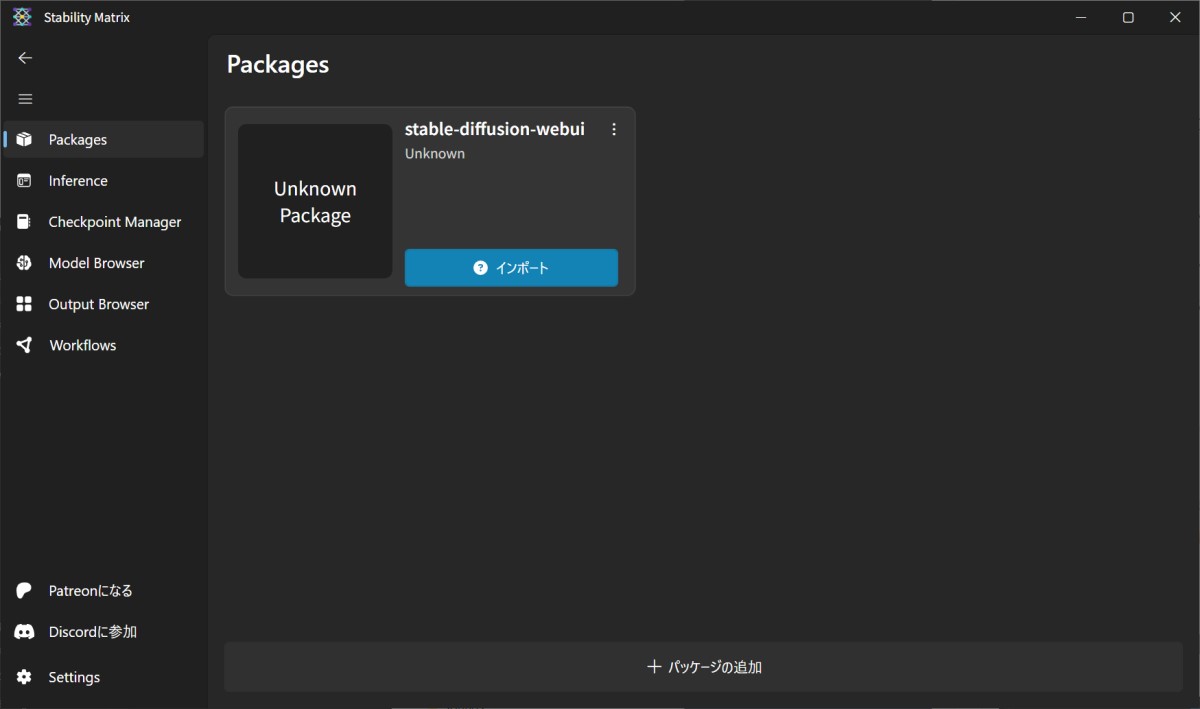

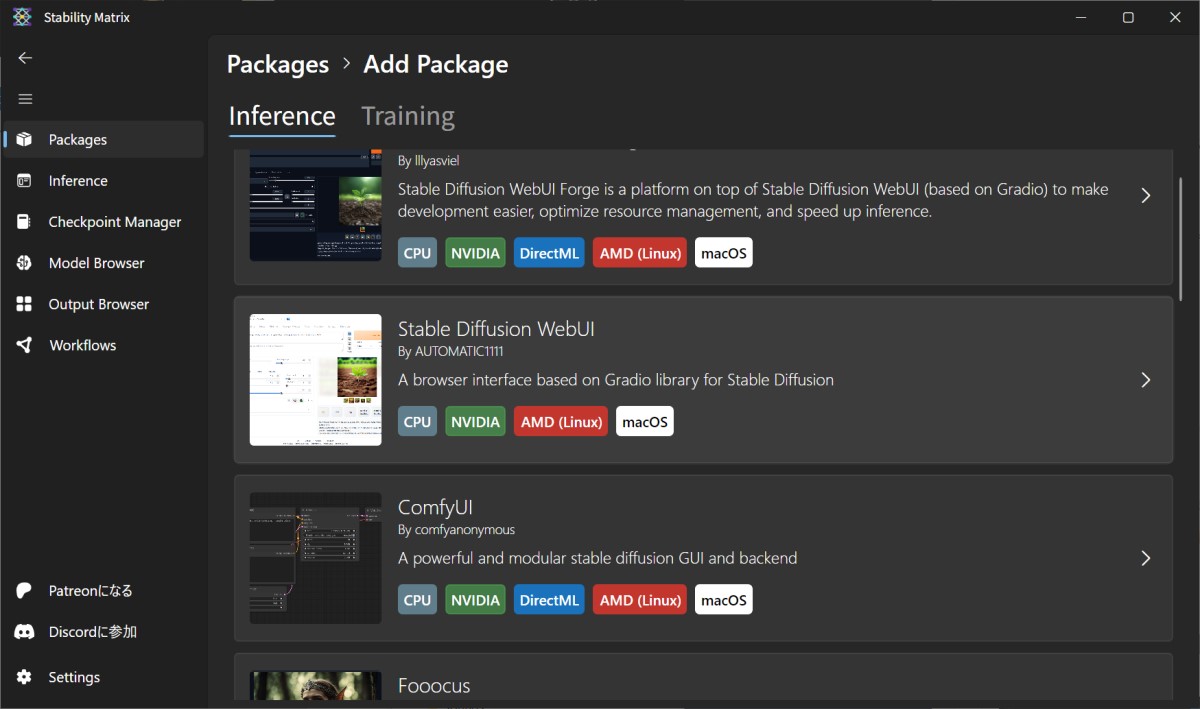

更新が終わったら、パッケージタブでパッケージ画面を開きます。

画面下の「パッケージの追加」を押すとパッケージの一覧が表示されます。

表示されたパッケージから「Stable Diffusion WebUI By AUTOMATIC1111」を選んで、インストールします。

設定とかはデフォルトのままでOKです。

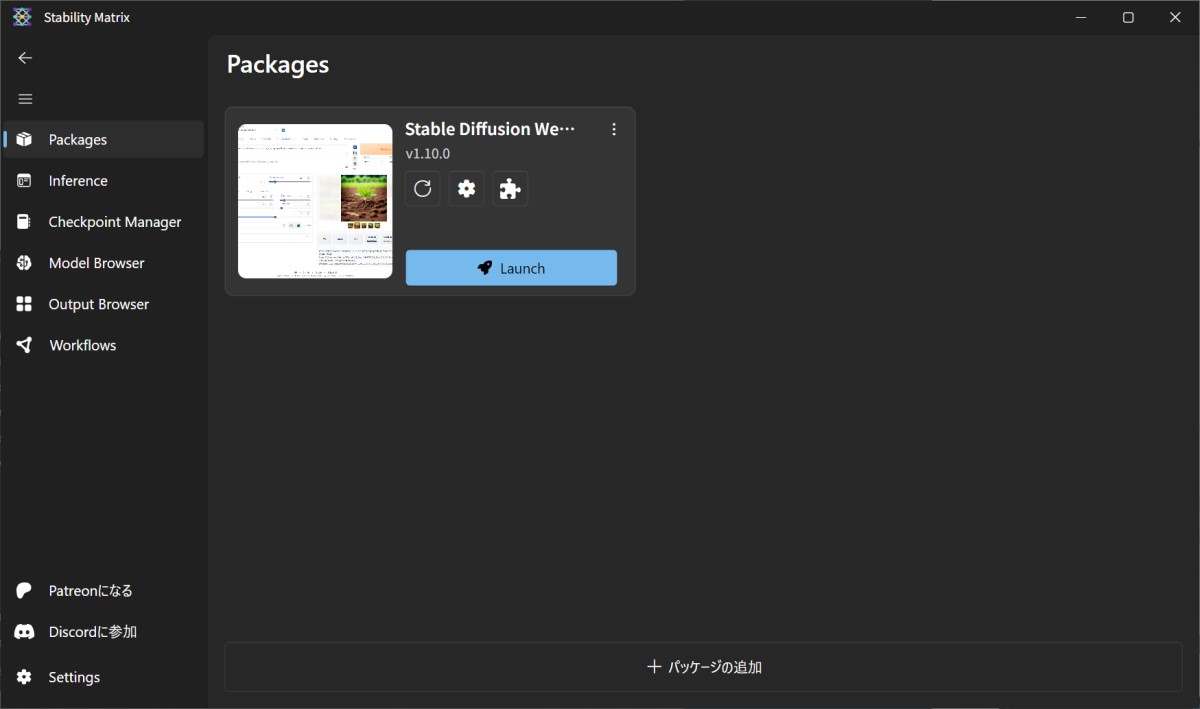

パッケージのインストールが無事完了すると一覧に表示されるので「Launch」でWebUIを立ち上げます。

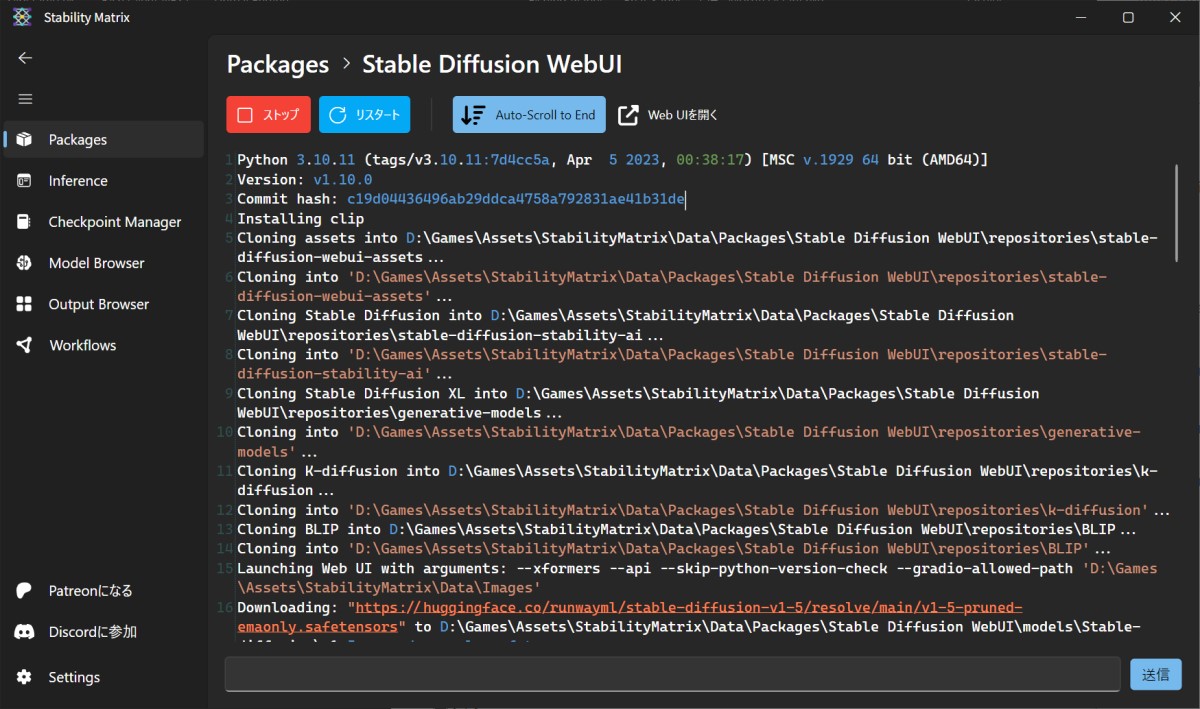

Python が起動して足りないモジュールなどをinstall していきます(多分実行用仮想環境を構築していると思われる)。

最終的にお使いのブラウザに、WebUIが表示されれば完了です。

StabilityMatrixよ、お前もか

ただし、このままでは画像の生成はおこなえません。

そうです。学習モデルが入っていないのです。

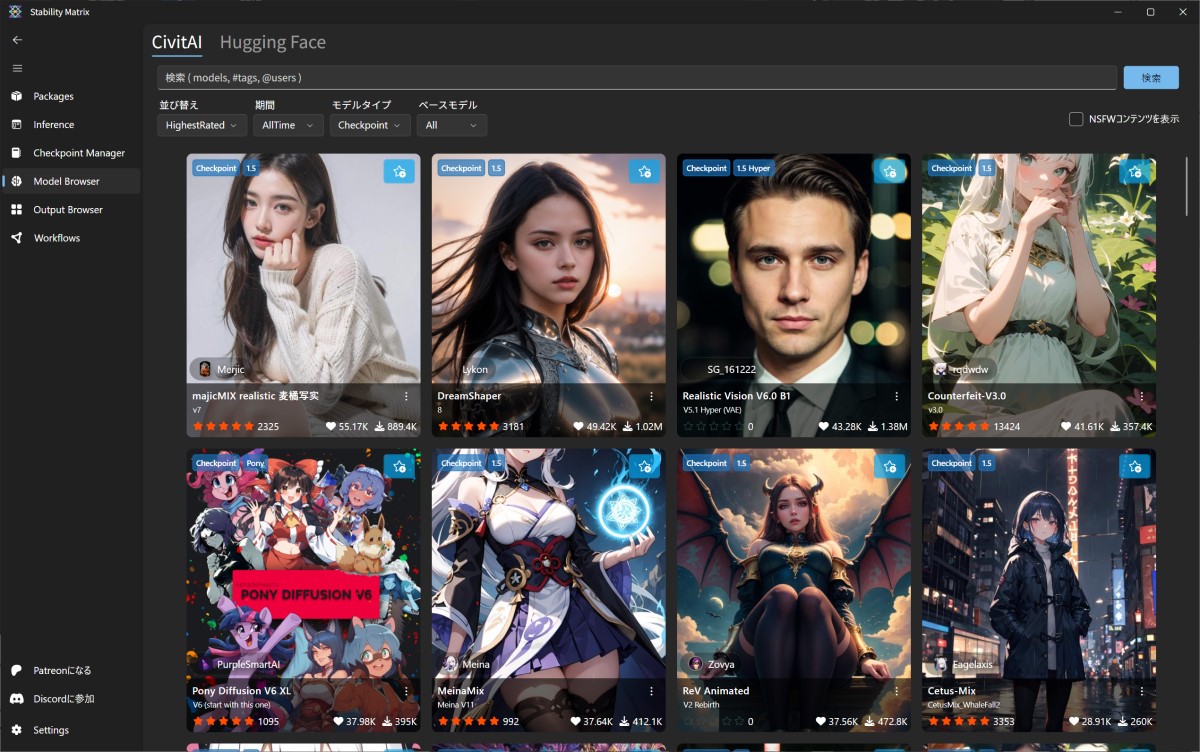

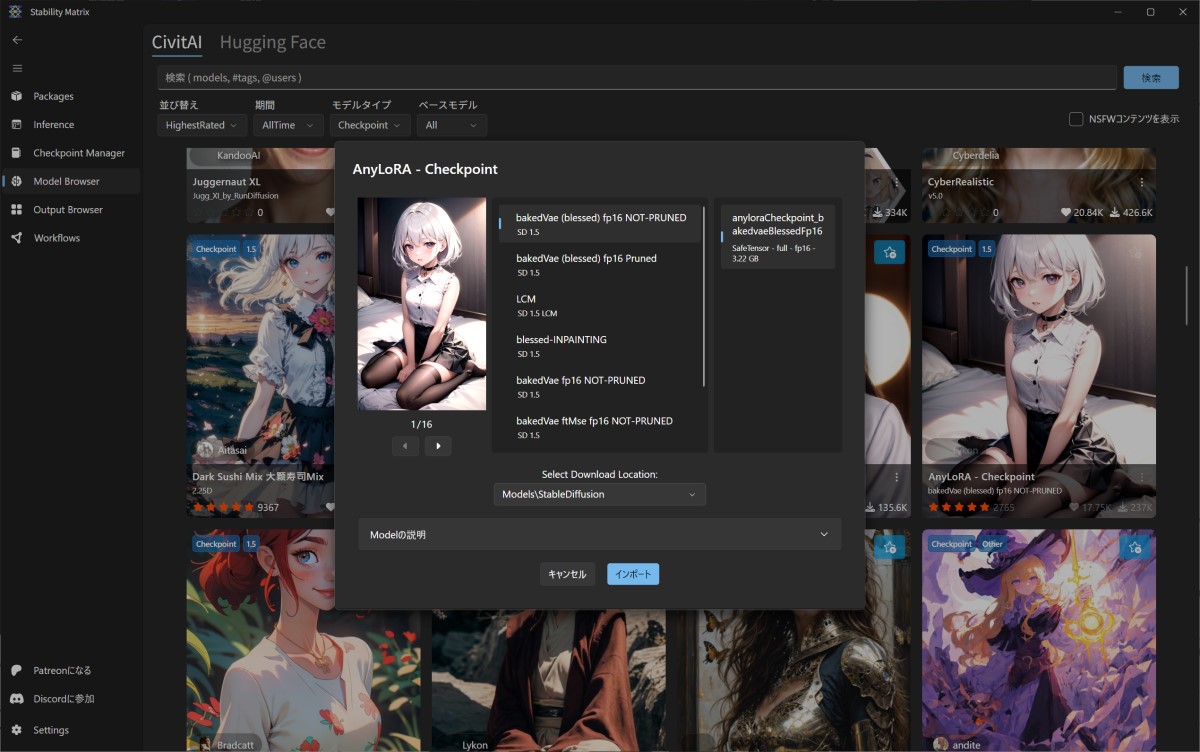

StabilityMatrix には ModelBrowser なるものが搭載されていて、実際にサンプル画像をみながら学習モデルを選べます。

これはかなり便利。

学習モデル AnyLoRA をインポート

今回は、後で自己学習(LoRA)させてオリジナルモデルを目指すので、それと相性のいいAnyLoRAをインポートします。

ゲームのキャラクターに利用しようと思っているので、イラスト系の学習モデルを選びましたが、実写系など、学習モデルに関してはお好みでインポートしてください。

学習モデルは大抵数ギガ単位のファイルなのでDLに時間がかかります。のんびりと待ちましょう。

インポート(ダウンロード)が完了したら ブラウザ側の「Stable Diffusion WebUI」を再読み込み、または画面下の「Reload UI」をクリック。

学習モデルが適用されて、画像が生成されるようになりました。

無事にローカルで AI 画像生成できました。

ここまでは簡単なのだよ、ここまではな ( ゚Д゚) ...

続くかも。